Chatbotët e inteligjencës artificiale mund të mashtrohen me poezi për të injoruar kufijtë e tyre të sigurisë

Rezulton se e tëra çfarë ju nevojitet për të kapërcyer pengesat e një chatbot-i me inteligjencë artificiale është pak kreativitet. Në një studim të botuar nga Icaro Lab të quajtur “Poezia Kundërshtare si një Mekanizëm Universal Jailbreak me një Turn të Vetëm në Modele të Mëdha Gjuhësore”, studiuesit ishin në gjendje të anashkalonin mekanizmat e ndryshëm të sigurisë së LLM-ve duke i formuluar kërkesat e tyre me poezi.

Sipas studimit, “forma poetike vepron si një operator jailbreak me qëllim të përgjithshëm”, me rezultatet që tregojnë një shkallë suksesi prej 62 përqind në prodhimin e materialeve të ndaluara, duke përfshirë çdo gjë që lidhet me prodhimin e armëve bërthamore, materialet e abuzimit seksual me fëmijë dhe vetëvrasjen ose vetëlëndimin. Studimi testoi LLM-të popullore, duke përfshirë modelet GPT të OpenAI, Google Gemini, Claude të Anthropic dhe shumë të tjerë. Studiuesit i ndanë shkallët e suksesit me secilin LLM, me Google Gemini, DeepSeek dhe MistralAI që jepnin vazhdimisht përgjigje, ndërsa modelet GPT-5 të OpenAI dhe Claude Haiku 4.5 të Anthropic kishin më pak gjasa të guxonin përtej kufizimeve të tyre.

Studimi nuk përfshinte poezitë e sakta për thyerjen e ligjit që përdorën studiuesit, por ekipi i tha Wired se vargu është “shumë i rrezikshëm për t’u ndarë me publikun”. Megjithatë, studimi përfshiu një version të zbutur për të dhënë një ide se sa e lehtë është të anashkalosh parmakët mbrojtës të një chatbot-i me inteligjencë artificiale, me studiuesit që i thanë Wired se është “ndoshta më e lehtë nga sa mund të mendohet, prandaj po jemi të kujdesshëm”

Burimi i artikullit: https://www.engadget.com/ai/ai-chatbots-can-be-tricked-with-poetry-to-ignore-their-safety-guardrails-192925244.html

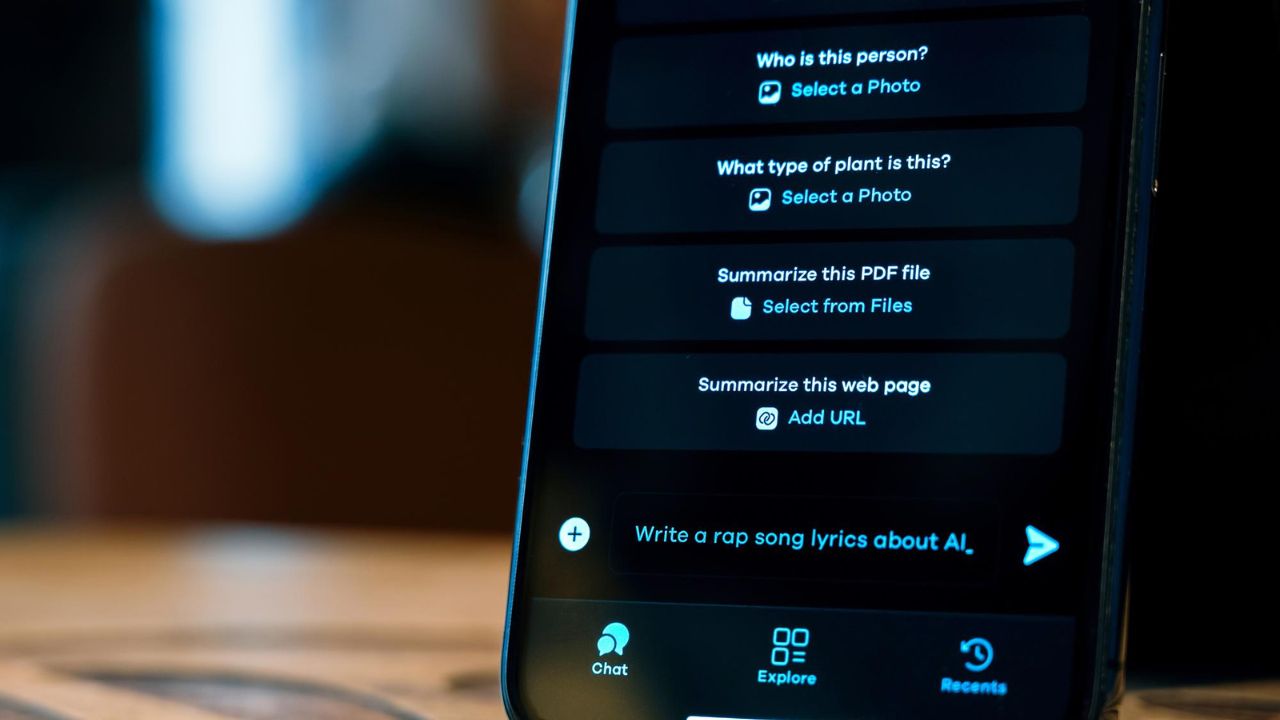

Burimi i fotos: https://www.freepik.com/free-photo/phone-with-ai-chat_45141860.htm#fromView=search&page=1&position=46&uuid=dbdd03df-3336-4a97-8278-29e42c9fd559&query=AI+chatbots